AI 윤리의 핵심은?

최근 AI는 우리의 삶에 아주 중요한 위치를 차지하고 있어요. 그래서 AI 윤리에 대한 고민은 정말 필수적이죠. 우리가 답해야 할 질문들을 하나하나 살펴보면서, AI가 어떻게 인간 중심적으로, 공정하게, 투명하게, 안전하게 그리고 책임감 있게 개발돼야 하는지 고민해볼게요.

AI는 인간 중심적으로 설계되어야 하나요?

AI가 인간 중심적 접근을 해야 한다고 생각해요. 우리가 AI를 설계할 때 사람의 결정권과 감정을 고려해야 하니까요. 예를 들어, 의료 인공지능이 환자의 진단을 내린다면, 결국 그 결정이 환자에게 미치는 영향을 고려해야겠죠. 인간의 능력을 향상시키고, 결정을 지원하는 방식으로 작동해야 합니다. 그렇지 않으면 사용자는 AI를 신뢰하지 않게 될 거예요.

AI는 공정해야 하나요?

그럼 AI의 공정성은 어떻게 보장할 수 있을까요? 이는 성별이나 인종에 따른 차별을 배제하는 것을 의미해요. 쉽게 말해, 어떤 사람에게는 유리하고 다른 사람에게는 불리한 데이터 사용이 이루어져선 안 된다는 거죠. AI는 사용자와 기업의 목표를 일치시키고, 모두에게 동등한 기회를 제공하는 방향으로 개발되어야 합니다. 그래서 AI가 공정해야 한다고 생각해요.

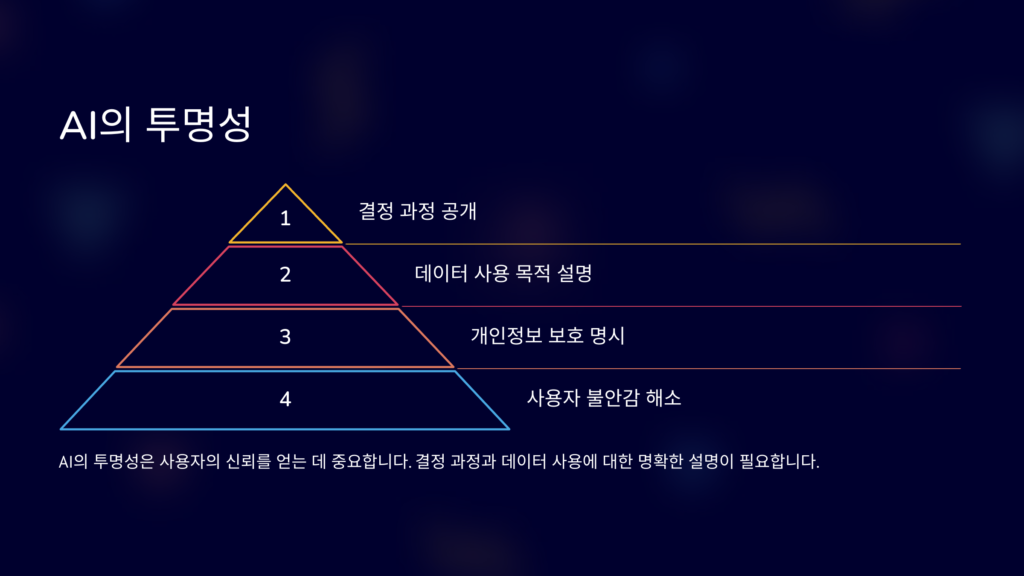

AI는 투명해야 하나요?

투명성도 매우 중요한 문제에요. 사용자에게 AI의 결정 과정과 데이터 사용 목적을 명확히 알려줘야 해요. 만약 사용자가 AI가 어떻게 결정을 내리는지 모른다면, 불안감을 느끼겠죠. 특히 개인정보 보호가 필수적이기 때문에, AI가 어떤 데이터를 수집하고 활용하는지에 대한 정확한 설명이 필요합니다. 즉, AI는 투명해야 한다는 것이죠.

AI는 안전해야 하나요?

그리고 안전성은 정말 빼놓을 수 없는 요소잖아요? AI는 사용자의 안전을 보장해야 해요. 만약 AI가 잘못된 결정을 내린다면, 그로 인해 발생할 수 있는 위험을 최소화해야 하죠. 예를 들어, 자율주행차나 의료 AI의 경우, 생명이 위태해질 수 있으므로 이 점에서 안전함은 생명과 직결된 문제입니다. 따라서 AI는 분명히 안전해야 해요.

AI 개발자는 책임을 질 수 있어야 하나요?

그럼 AI 개발자는 어떤 책임을 져야 할까요? AI가 내놓은 결정이나 결과에 대해 개발자가 책임을 져야 하는 것은 당연해요. AI 시스템이 잘못 작동했을 경우 어떠한 윤리적 원칙을 구현해야 할지 고민하고, 지속적인 윤리적 교육이 필요하다고 생각해요. AI가 사회에 미치는 영향은 크기 때문에, 개발자들이 그 결과에 대해 실질적인 책임을 져야 합니다.

결론

결과적으로, AI 윤리는 단순한 기술적 문제를 넘어서서 사회적, 윤리적 책임을 포함해야 해요. 인간 중심적 접근, 공정성, 투명성, 안전함, 그리고 개발자의 책임감을 통해 우리는 더 나은 AI를 설계할 수 있습니다. 그리고 이러한 질문들을 하나씩 해결해 나가면서, AI의 미래를 더욱 밝게 만들 수 있을 거라고 믿습니다.

자주 묻는 질문

자주 묻는 질문

AI 윤리는 왜 중요한가요?

AI 윤리는 기술이 사회에 미치는 영향과 위험을 고려해야 하기 때문에 중요해요. 이를 통해 AI가 공정하고 안전하게 활용될 수 있도록 보장할 수 있습니다.

AI는 어떻게 공정함을 유지하나요?

AI가 공정함을 유지하려면 성별, 인종 등의 편향을 제거한 데이터를 사용해야 하고, 지속적으로 모니터링하여 공정성을 평가해야 해요.

AI 개발자는 어떤 책임을 져야 하나요?

AI 개발자는 AI 시스템의 결과에 대해 윤리적 책임을 져야 하고, 사용자에게 발생할 수 있는 위험을 최소화하는 방향으로 개발을 해야 해요.